11 janvier 2024

La vérification d'identité à distance est l'un des défis les plus urgents de notre ère de plus en plus numérique. Confirmer l'identité d'une personne sans la voir physiquement, en personne, est un besoin qui ne cesse de croître en importance et en difficulté.

L'une des menaces les plus insidieuses pour la vérification d'identité à distance est l'utilisation de "deepfakes" créés par l'IA générative. Les deepfakes ne sont pas intrinsèquement dangereux, mais ils peuvent constituer des menaces importantes pour la sécurité. Comme il est désormais impossible de distinguer de manière fiable l'imagerie synthétique de l'imagerie réelle avec l'œil humain, la biométrie alimentée par l'IA s'est imposée comme la défense la plus solide contre les deepfakes - et, par conséquent, comme la seule méthode fiable de vérification d'identité à distance. En fait, la lutte contre les deepfakes nécessite une recherche continue et des solutions critiques avec une sécurité évolutive. Les gens apprécient également la commodité de la vérification biométrique faciale - 72 % des consommateurs dans le monde préfèrent la vérification faciale pour la sécurité en ligne.

Cependant, à mesure que la technologie biométrique progresse, les acteurs malveillants cherchent de nouvelles méthodes plus sophistiquées pour compromettre ces systèmes. Il est toutefois important de rappeler que les "deepfakes" ne constituent pas une menace pour la sécurité biométrique , mais pour toute méthode de vérification à distance de l'identité d'un être humain.

La menace Deepfake : Un regard sur la montée en puissance de la technologie Deepfake

Au début, les deepfakes n'étaient qu'un amusement inoffensif, les gens créant des vidéos et des images à des fins de divertissement. Cependant, lorsqu'ils sont associés à des intentions malveillantes et à des outils de cyberattaque, ils se transforment rapidement en menaces sinistres. Les "deepfakes" sont rapidement devenus un moyen très puissant de lancer des attaques de cybersécurité, de diffuser des "fake news" et d'influencer l'opinion publique. Vous êtes probablement déjà tombé sur un deepfake sans même vous en rendre compte.

La technologie Deepfake implique l'utilisation d'outils tels que l'imagerie générée par ordinateur (CGI) et l'intelligence artificielle pour modifier l'apparence et le comportement d'une personne. Des algorithmes d'apprentissage automatique permettent de générer des contenus synthétiques très réalistes afin d'imiter les comportements humains, notamment les expressions faciales et la parole. Lorsqu'elle est utilisée à des fins malveillantes, cette technologie peut servir à créer de fausses identités, à imiter des personnes et à accéder à des lieux sécurisés, par exemple.

En raison de la sophistication de la technologie, le contenu des deepfakes semble souvent très réaliste pour des humains formés et même pour certaines solutions de vérification d'identité, ce qui rend difficile la distinction entre authentique et synthétique. L'évolution rapide de l'IA signifie que les deepfakes évoluent également en permanence - il ne s'agit pas d'une menace statique.

Détection des Deepfakes : Il est prouvé que les humains ne peuvent pas détecter de manière fiable les Deepfakes

Nous avons compilé une liste d'études qui montrent que les humains ne sont tout simplement pas un indicateur fiable pour repérer les "deepfakes" :

- Une étude réalisée en 2021 et intitulée "Deepfake detection by human crowds, machines, and machine-informed crowds" a révélé que les personnes seules sont bien moins performantes que les algorithmes de détection. Les algorithmes de détection ont même été plus performants que les médecins légistes, qui sont bien plus compétents que le commun des mortels. L'étude n'a pas non plus démontré que l'éducation/la formation améliorait les performances.

- Une autre étude réalisée en 2021 et intitulée "Fooled twice : People cannot detect deepfakes but think they can" a révélé que les gens sont moins capables d'identifier les deepfakes qu'ils ne le pensent, qu'ils ne sont pas fiables pour détecter les contenus vidéo manipulés, que la formation et les incitations n'augmentent pas les capacités, que les gens ont un biais en faveur d'un taux de rejet erroné et, enfin, que les gens sont particulièrement susceptibles d'être influencés par les contenus de deepfake.

- En 2022, un groupe de chercheurs en sécurité a découvert que la vérification des appels vidéo de personne à personne pouvait être facilement contournée avec un logiciel OS et de l'aquarelle (c'est-à-dire de la manipulation d'art numérique). Cela montre que les systèmes d'identification vidéo par un opérateur humain sont facilement surmontables avec des approches quotidiennes de base et très peu de compétences - parfois, il n'est même pas nécessaire d'avoir recours à des "deepfakes" pour tromper les humains.

Voyez si vous pouvez repérer un deepfake dans notre quiz interactif!

Comment les Deepfakes menacent toutes les vérifications d'identité en ligne

Pour vérifier l'identité à distance de manière fiable, vous devez voir la personne et sa pièce d'identité. La vérification par appel vidéo - parfois appelée identification vidéo - consiste à parler à une personne en chair et en os par l'intermédiaire d'un logiciel d'appel vidéo afin de prouver son identité. Il s'agit toutefois d'une option peu souhaitable, notamment parce qu'elle n'est pas pratique, qu'elle demande beaucoup de travail et d'argent et qu'elle ne peut pas être automatisée (il est donc plus difficile de l'adapter).

Les deepfakes peuvent de toute façon être injectés dans un flux vidéo en direct, ils constituent donc une menace encore plus grave pour la vérification vidéo. Comme nous l'avons établi, les humains sont moins fiables pour détecter les deepfakes que les données biométriques. C'est pourquoi nous rappelons aux organisations que les deepfakes et autres formes d'IA générative ne constituent pas un "problème biométrique", mais un problème de vérification d'identité à distance.

La vérification à distance de l'identité est essentielle pour la majorité des organisations qui exercent des activités en ligne. Dans de nombreux cas, elle n'est pas négociable. Face à la menace des "deepfakes", les organisations doivent utiliser l'IA pour le bien de la cybersécurité (c'est-à-dire la biométrie alimentée par l'IA).

Ne puis-je pas vérifier les utilisateurs à l'aide d'une autre méthode biométrique, afin d'éviter les "deepfakes" ?

Vous pourriez ensuite vous demander "Pourquoi les autres méthodes biométriques ne constituent-elles pas une alternative appropriée pour la vérification de l'identité ? Ne peut-on pas simplement utiliser l'iris ou l'authentification vocale, afin de ne pas avoir à se préoccuper des deepfakes ?"

La vérification biométrique du visage s'est imposée comme la seule méthode fiable de vérification d'identité à distance :

- Les autres méthodes biométriques ne peuvent pas vérifier l'identité. Elles ne peuvent que l'authentifier. En effet, votre voix, votre iris, etc. ne figurent généralement sur aucun de vos documents d'identité (contrairement à votre visage). Vous ne disposez donc d'aucun élément de confiance pour vérifier les données biométriques - aucune source de vérité. C'est possible dans de rares cas - peut-être qu'une organisation a accès à des données d'empreintes digitales officielles, par exemple. Mais elle n'est pas extensible comme l'est la vérification des visages. Il en va de même pour les méthodes traditionnelles, telles que les mots de passe et les OTP, qui n'ont absolument pas réussi à assurer la sécurité des utilisateurs en ligne. On ne peut pas être sûr à 100 % de l'identité d'une personne simplement parce qu'elle sait quelque chose (un mot de passe) ou possède quelque chose (un téléphone avec un code).

- Le clonage par l'IA est une menace pour toutes les méthodes biométriques. La voix, par exemple, est considérée comme la méthode biométrique la plus facile à cloner. Vous pouvez en savoir plus sur la menace du clonage de la voix dans cet article et sur les inconvénients de la biométrie vocale ici.

Se prémunir contre les attaques Deepfake

Lorsque nous parlons de la menace que représentent les "deepfakes", il s'agit de souligner à quel point une solution de vérification faciale robuste est essentielle pour s'en prémunir, et d'éduquer les organisations sur les différences conséquentes entre les solutions disponibles.

Comme l'indique le Guide du marché 2023 de Gartner, "les responsables de la sécurité et de la gestion des risques doivent faire de la détection des contrefaçons une exigence clé et se méfier de tout fournisseur qui ne discute pas de manière proactive de ses capacités".

Plusieurs mesures peuvent être mises en œuvre pour atténuer les risques associés aux attaques de type "deepfake" sur les systèmes biométriques :

- Biométrie multimodale : La combinaison de plusieurs méthodes biométriques, telles que la vérification faciale et le balayage des empreintes digitales, peut renforcer la sécurité en rendant plus difficile pour les attaquants de falsifier plusieurs modalités simultanément.

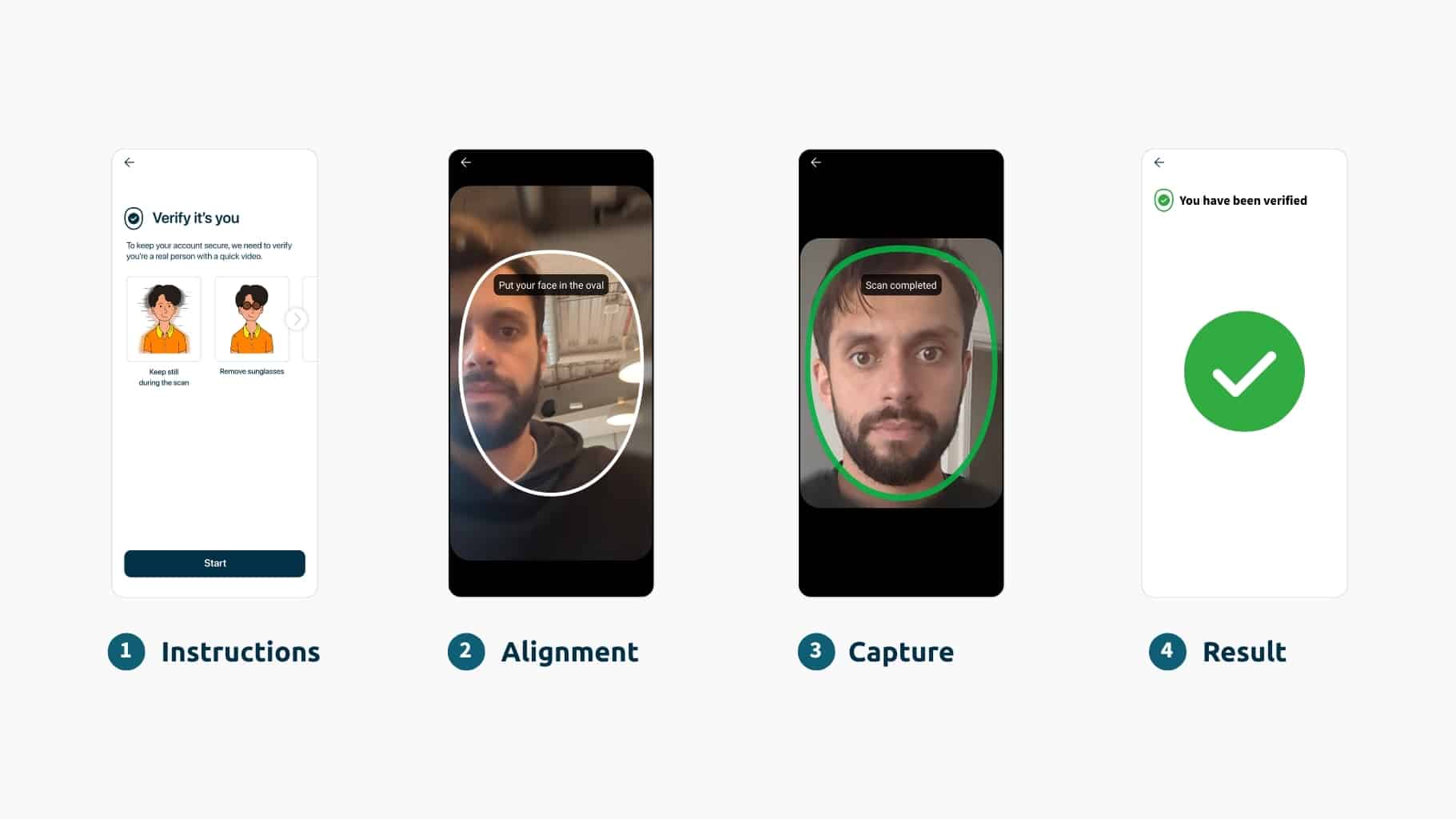

- Détection du caractère vivant : La mise en œuvre de contrôles de détection du caractère vivant fondés sur la science peut aider à différencier les données biométriques réelles des représentations synthétiques, telles que les "deepfakes" qui ne présentent pas de signes vitaux de vie. Pour en savoir plus sur la technologie de détection du caractère vivant, cliquez ici.

- Surveillance continue : Les systèmes biométriques devraient intégrer une surveillance continue et une détection des anomalies afin d'identifier des modèles ou des comportements inhabituels pouvant indiquer une attaque de type "deepfake". Les organisations doivent adopter des techniques avancées capables de s'adapter à l'accélération rapide du paysage des cybermenaces (et non celles qui reposent sur des défenses statiques - la solution est un service évolutif plutôt qu'un logiciel).

Les solutions biométriques techniques telles que la détection scientifique de la vivacité et l'intelligence active des menaces occuperont une place centrale dans l'identification des médias synthétiques. Toutefois, la recherche humaine et l'esprit critique restent essentiels lorsqu'il s'agit d'identifier des menaces potentielles. La solution ultime consiste à combiner les forces de l'homme et de l'automatisation pour créer une solution infaillible - comme le fait iProov, en utilisant notre vérification biométrique critique avec nos capacités iSOC.

La question "comment pouvons-nous être sûrs de l'identité d'une personne en ligne ?" est un sujet extrêmement important et sérieux, et il n'est pas près de disparaître.

Pour en savoir plus sur la manière dont iProov se défend spécifiquement contre les deepfakes, consultez cet article de blog et lisez notre rapport, Deepfakes : La nouvelle frontière de la criminalité en ligne.