11 gennaio 2024

La verifica dell'identità a distanza è una delle sfide più urgenti della nostra era sempre più digitale. Confermare l'identità di una persona senza vederla fisicamente è un'esigenza che continua a crescere sia per importanza che per difficoltà.

Tra le minacce più insidiose alla verifica dell'identità a distanza c'è l'uso di deepfakes creati dall'intelligenza artificiale generativa. I deepfakes non sono intrinsecamente dannosi, ma possono rappresentare una minaccia significativa per la sicurezza. Poiché è ormai impossibile distinguere in modo affidabile le immagini sintetiche da quelle reali con l'occhio umano, la biometria basata sull'IA è emersa come la difesa più solida contro i deepfakes e, quindi, l'unico metodo affidabile di verifica dell'identità a distanza. In realtà, per combatterli è necessaria una ricerca continua e soluzioni mission-critical con una sicurezza in continua evoluzione. Le persone apprezzano anche la comodità della verifica biometrica facciale: il 72% dei consumatori di tutto il mondo preferisce la verifica facciale per la sicurezza online.

Tuttavia, con il progredire della tecnologia biometrica, i malintenzionati cercano nuovi e più sofisticati metodi per compromettere questi sistemi. È importante ricordare, tuttavia, che i deepfakes non sono una minaccia per la sicurezza biometrica , ma per qualsiasi metodo di verifica dell'identità umana a distanza.

La minaccia Deepfake: Uno sguardo all'interno dell'ascesa della tecnologia Deepfake

All'inizio, i deepfake erano solo un divertimento innocuo, con persone che creavano video e immagini a scopo di intrattenimento. Tuttavia, se combinati con intenti malevoli e strumenti di attacco informatico, si trasformano rapidamente in minacce sinistre. I deepfake sono diventati rapidamente un modo molto potente per lanciare attacchi di cybersicurezza, diffondere fake news e influenzare l'opinione pubblica. Probabilmente vi siete già imbattuti in un deepfake senza nemmeno accorgervene.

La tecnologia Deepfake prevede l'uso di strumenti come le immagini generate al computer (CGI) e l'intelligenza artificiale per alterare l'aspetto e il comportamento di qualcuno. Gli algoritmi di apprendimento automatico lavorano per generare contenuti sintetici altamente realistici per imitare i comportamenti umani, comprese le espressioni facciali e il linguaggio. Se usata in modo malevolo, questa tecnologia può essere impiegata per creare identità contraffatte, imitare persone e ottenere l'accesso a luoghi sicuri, ad esempio.

Grazie alla sofisticazione della tecnologia, i contenuti deepfake appaiono spesso molto realistici agli esseri umani addestrati e persino ad alcune soluzioni di verifica dell'identità, rendendo difficile discernere quelli autentici da quelli sintetici. La rapida evoluzione dell'intelligenza artificiale significa che anche i deepfake sono in continua evoluzione: non sono una minaccia statica.

Rilevamento dei deepfake: Le prove stabiliscono che gli esseri umani non sono in grado di individuare in modo affidabile i deepfake

Abbiamo compilato un elenco di studi che evidenziano come gli esseri umani non siano un indicatore affidabile per individuare i deepfakes:

- Uno studio del 2021 intitolato "Deepfake detection by human crowds, machines, and machine-informed crowds" ha rilevato che le persone da sole fanno molto peggio degli algoritmi di rilevamento. Gli algoritmi di rilevamento hanno persino superato gli esaminatori forensi, che sono molto più abili nel compito di una persona media. Lo studio non ha inoltre rilevato alcuna prova che l'istruzione/formazione migliori le prestazioni.

- Un altro studio del 2021, intitolato "Fooled twice: People cannot detect deepfakes but think they can", ha rilevato che le persone sono meno capaci di identificare i deepfakes di quanto pensino; che le persone non sono affidabili nel rilevare i contenuti video manipolati; che la formazione e gli incentivi non aumentano l'abilità; che le persone hanno un pregiudizio verso un False Rejection Rate; e infine che le persone sono particolarmente suscettibili di essere influenzate da contenuti deepfake.

- Nel 2022, un gruppo di ricercatori di sicurezza ha scoperto che la verifica delle videochiamate da persona a persona può essere facilmente superata con il software OS e l'acquerello (cioè la manipolazione dell'arte digitale). Questo dimostra che i sistemi di identificazione video da parte di un operatore umano sono facilmente superabili con approcci quotidiani di base e con pochissime abilità: a volte non sono necessari nemmeno i deepfake per ingannare gli esseri umani.

Scopri se riesci a individuare un deepfake nel nostro quiz interattivo!

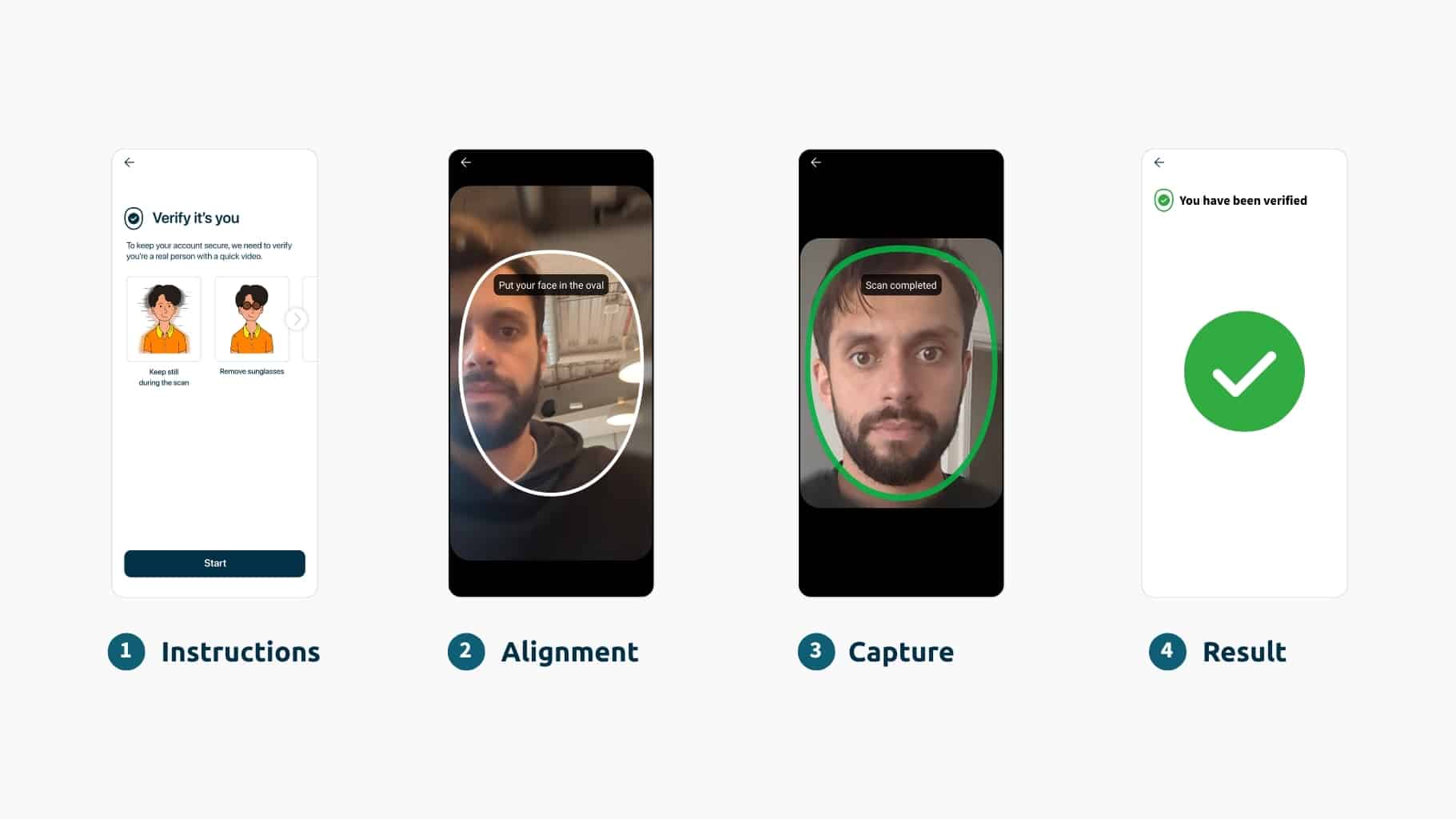

Come i deepfake minacciano tutte le verifiche di identità online

Per verificare in modo affidabile l'identità a distanza, è necessario vedere la persona e il suo documento d'identità. La verifica tramite videochiamata, talvolta nota come identificazione video, si riferisce al processo di parlare con una persona in carne e ossa tramite un software di videochiamata per dimostrare la propria identità. Si tratta però di un'opzione indesiderata, non da ultimo perché è scomoda, richiede molto lavoro e costi e non può essere automatizzata (quindi è più difficile da scalare).

I deepfake possono comunque essere inseriti in un flusso video in diretta, quindi rappresentano una minaccia ancora più critica per la verifica video. Come abbiamo stabilito, gli esseri umani sono meno affidabili nel rilevare i deepfake rispetto alla biometria. Per questo motivo invitiamo le organizzazioni a ricordare che i deepfake e altre forme di IA generativa non sono un "problema biometrico", ma un problema di verifica dell'identità a distanza.

La verifica dell'identità a distanza è fondamentale per la maggior parte delle organizzazioni che operano online. In molti casi non è negoziabile. Contro la minaccia dei deepfakes, le organizzazioni devono utilizzare l'IA per il bene della cybersecurity (cioè la biometria alimentata dall'IA).

Non è possibile verificare gli utenti con un altro metodo biometrico per evitare del tutto i deepfakes?

Ci si potrebbe poi chiedere: "Perché altri metodi biometrici non sono un'alternativa adeguata per la verifica dell'identità? Non si può semplicemente usare l'iride o l'autenticazione vocale, in modo da non avere a che fare con i deepfake?".

La verifica biometrica del volto, in particolare, è emersa come l'unico metodo affidabile di verifica dell'identità a distanza perché:

- Altri metodi biometrici non possono verificare l'identità. Possono solo autenticarla. Questo perché la voce, l'iride e così via non sono generalmente presenti su alcun documento d'identità (a differenza del viso). Quindi non c'è nulla di attendibile con cui verificare i dati biometrici, nessuna fonte di verità. È possibile in rari casi, ad esempio quando un'organizzazione ha accesso ai dati ufficiali delle impronte digitali. Ma non è scalabile come la verifica del volto. Lo stesso vale per i metodi tradizionali, come le password e gli OTP, che hanno fallito completamente nel mantenere la sicurezza degli utenti online. Non si può essere certi al 100% dell'identità di qualcuno solo perché conosce qualcosa (una password) o possiede qualcosa (un telefono con un codice).

- La clonazione guidata dall'intelligenza artificiale è una minaccia per tutti i metodi biometrici. La voce, ad esempio, è considerata la biometria più facile da clonare. Per saperne di più sulla minaccia della clonazione vocale, leggete questo articolo e sugli svantaggi della biometria vocale qui.

Protezione contro gli attacchi Deepfake

Quando parliamo della minaccia dei deepfake, sottolineiamo quanto sia fondamentale una solida soluzione di verifica facciale per difendersi da questi fenomeni e per educare le organizzazioni sulle differenze conseguenti tra le soluzioni disponibili.

Come si legge nella Guida al mercato 2023 di Gartner, "i responsabili della sicurezza e della gestione del rischio devono fare del rilevamento dei deepfake un requisito fondamentale e devono diffidare di qualsiasi fornitore che non parli in modo proattivo delle sue capacità".

Per mitigare i rischi associati agli attacchi deepfake sui sistemi biometrici, è possibile implementare diverse misure:

- Biometria multimodale: La combinazione di più metodi biometrici, come la verifica facciale e la scansione delle impronte digitali, può migliorare la sicurezza rendendo più difficile per gli aggressori falsificare più modalità contemporaneamente.

- Rilevamento della vivacità: L'implementazione di controlli di liveness detection basati su dati scientifici può aiutare a distinguere tra dati biometrici reali e rappresentazioni sintetiche, come i deepfake che non presentano segni vitali. Per saperne di più sulla tecnologia Liveness, cliccate qui.

- Monitoraggio continuo: I sistemi biometrici devono incorporare il monitoraggio continuo e il rilevamento delle anomalie per identificare modelli o comportamenti insoliti che potrebbero indicare un attacco deepfake. Le organizzazioni devono adottare tecniche avanzate in grado di adattarsi alla rapida accelerazione del panorama delle minacce informatiche (non quelle che si basano su difese statiche - la soluzione è un servizio in evoluzione piuttosto che un software).

Le soluzioni biometriche tecniche, come il rilevamento della vivacità basato sulla scienza e l'intelligence attiva delle minacce, saranno al centro dell'attenzione nell'identificazione dei media sintetici. Tuttavia, la ricerca umana e le capacità di pensiero critico sono ancora essenziali quando si tratta di identificare potenziali minacce. La soluzione definitiva consiste nel combinare i punti di forza dell'uomo e dell'automazione per creare una soluzione infallibile, come fa iProov, utilizzando la nostra verifica biometrica mission-critical con le nostre capacità iSOC.

La domanda "come possiamo essere sicuri dell'identità di una persona online?" è un argomento estremamente importante e serio, e non è destinata a scomparire.

Per saperne di più su come iProov si difende in modo specifico dai deepfakes, leggete questo post sul blog e il nostro rapporto, Deepfakes: La nuova frontiera del crimine online.