11 มกราคม 2024

การยืนยันตัวตนจากระยะไกลเป็นหนึ่งในความท้าทายที่เร่งด่วนที่สุดในยุคดิจิทัลที่เพิ่มมากขึ้นของเรา การยืนยันตัวตนของบุคคลโดยไม่เห็นพวกเขาทางกายภาพด้วยตนเองเป็นความต้องการที่ยังคงเติบโตทั้งในความสําคัญ และ ความยากลําบาก

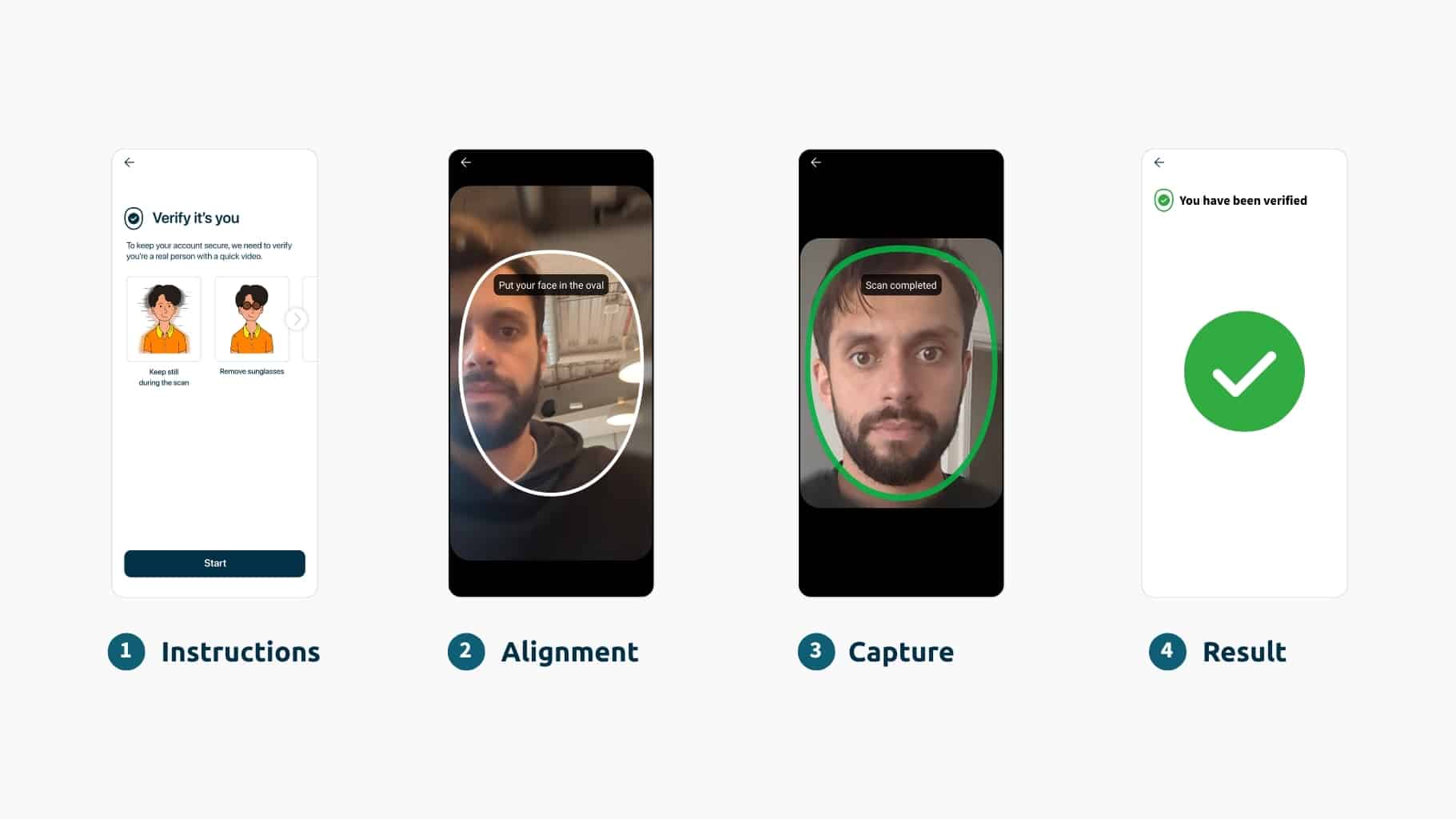

ภัยคุกคามที่ร้ายกาจที่สุดในการยืนยันตัวตนจากระยะไกลคือการใช้ Generative AI ที่สร้าง Deepfake Deepfakes ไม่เป็นอันตรายภายใน แต่อาจก่อให้เกิดภัยคุกคามด้านความปลอดภัยที่สําคัญได้ เนื่องจากตอนนี้ เป็นไปไม่ได้ที่จะแยกความแตกต่างระหว่างภาพสังเคราะห์และภาพจริงด้วยตามนุษย์ได้อย่างน่าเชื่อถือไบโอเมตริกที่ขับเคลื่อนด้วย AI ได้กลายเป็นการป้องกันที่แข็งแกร่งที่สุดจาก Deepfake ดังนั้นจึงเป็นวิธีเดียวที่เชื่อถือได้ในการยืนยันตัวตนระยะไกล ในความเป็นจริงการต่อสู้กับพวกเขาจําเป็นต้องมีการวิจัยอย่างต่อเนื่องและการแก้ปัญหาที่สําคัญต่อภารกิจพร้อม ความปลอดภัยที่พัฒนาขึ้น ผู้คนให้ความสําคัญกับความสะดวกสบายของการตรวจสอบไบโอเมตริกซ์ด้วยใบหน้าเช่นกัน – 72% ของผู้บริโภคทั่วโลกชอบการตรวจสอบใบหน้า เพื่อความปลอดภัยทางออนไลน์

อย่างไรก็ตามเมื่อเทคโนโลยีไบโอเมตริกซ์ก้าวหน้าผู้ประสงค์ร้ายจะค้นหาวิธีการใหม่และซับซ้อนมากขึ้นเพื่อประนีประนอมระบบเหล่านี้ อย่างไรก็ตาม สิ่งสําคัญคือต้องจําไว้ว่า Deepfake ไม่ใช่ภัยคุกคามต่อความปลอดภัยไบโอเมตริกซ์ แต่เป็นภัยคุกคามต่อวิธีการใดๆ ในการยืนยันตัวตนของมนุษย์จากระยะไกล

ภัยคุกคาม Deepfake: ดูภายในการเพิ่มขึ้นของเทคโนโลยี Deepfake

ในตอนแรก Deepfake เป็นเพียงความสนุกที่ไม่เป็นอันตราย โดยผู้คนสร้างวิดีโอและรูปภาพเพื่อความบันเทิง อย่างไรก็ตามเมื่อรวมกับเจตนาร้ายและเครื่องมือโจมตีทางไซเบอร์พวกมันจะกลายเป็นภัยคุกคามที่น่ากลัวอย่างรวดเร็ว Deepfakes ได้กลายเป็นวิธีที่มีประสิทธิภาพมากอย่างรวดเร็วในการโจมตีความปลอดภัยทางไซเบอร์เผยแพร่ข่าวปลอมและโน้มน้าวความคิดเห็นของสาธารณชน คุณอาจเคยเจอ Deepfake โดยไม่รู้ตัว

เทคโนโลยี Deepfake เกี่ยวข้องกับการใช้เครื่องมือต่างๆ เช่น ภาพที่สร้างด้วยคอมพิวเตอร์ (CGI) และปัญญาประดิษฐ์เพื่อเปลี่ยนรูปลักษณ์และพฤติกรรมของใครบางคน อัลกอริทึมแมชชีนเลิร์นนิงทํางานเพื่อสร้างเนื้อหาสังเคราะห์ที่สมจริงอย่างมากเพื่อเลียนแบบพฤติกรรมของมนุษย์ รวมถึงการแสดงออกทางสีหน้าและคําพูด เมื่อใช้อย่างมุ่งร้ายเทคโนโลยีนี้สามารถใช้เพื่อสร้างข้อมูลประจําตัวปลอมเลียนแบบผู้คนและเข้าถึงสถานที่ที่ปลอดภัยเป็นต้น

เนื่องจากความซับซ้อนของเทคโนโลยี เนื้อหา Deepfake มักจะดูสมจริงอย่างมากสําหรับมนุษย์ที่ได้รับการฝึกฝนและแม้แต่โซลูชันการยืนยันตัวตนบางอย่าง ทําให้ยากต่อการแยกแยะจากของแท้จากสารสังเคราะห์ การพัฒนาอย่างรวดเร็วของ AI หมายความว่า Deepfake มีการพัฒนาอย่างต่อเนื่องเช่นกัน – ไม่ใช่ภัยคุกคามแบบคงที่

การตรวจจับ Deepfake: หลักฐานระบุว่ามนุษย์ไม่สามารถตรวจจับ Deepfake ได้อย่างน่าเชื่อถือ

เราได้รวบรวมรายชื่อการศึกษาที่เน้นว่ามนุษย์ไม่ใช่ตัวบ่งชี้ที่เชื่อถือได้สําหรับการตรวจหา Deepfakes:

- การศึกษาในปี 2021 เรื่อง "การตรวจจับ Deepfake โดยฝูงชน เครื่องจักร และฝูงชนที่ได้รับแจ้งจากเครื่อง" พบว่าผู้คนเพียงอย่างเดียวนั้นแย่กว่าอัลกอริธึมการตรวจจับมาก อัลกอริธึมการตรวจจับมีประสิทธิภาพเหนือกว่าผู้ตรวจสอบทางนิติวิทยาศาสตร์ซึ่งมีทักษะในงานมากกว่าคนทั่วไปมาก การศึกษายังไม่พบหลักฐานว่าการศึกษา/การฝึกอบรมช่วยเพิ่มประสิทธิภาพ

- การศึกษาอีกชิ้นในปี 2021 ชื่อ "Fooled สองครั้ง: ผู้คนไม่สามารถตรวจจับ Deepfake ได้ แต่คิดว่าทําได้" พบว่าผู้คนสามารถระบุ Deepfake ได้น้อยกว่าที่พวกเขาคิด ว่าผู้คนไม่น่าเชื่อถือในการตรวจจับเนื้อหาวิดีโอที่ถูกบิดเบือน การฝึกอบรมและสิ่งจูงใจนั้นไม่ได้เพิ่มความสามารถ ว่าผู้คนมีอคติต่ออัตราการปฏิเสธที่ผิดพลาด และสุดท้ายคือผู้คนมีความอ่อนไหวเป็นพิเศษต่อการได้รับอิทธิพลจากเนื้อหา Deepfake

- ในปี 2022 กลุ่มนักวิจัยด้านความปลอดภัยพบว่า การตรวจสอบแฮงเอาท์วิดีโอแบบตัวต่อตัวสามารถเอาชนะได้อย่างง่ายดาย ด้วยซอฟต์แวร์ระบบปฏิบัติการและสีน้ํา (เช่น การจัดการงานศิลปะดิจิทัล) นี่แสดงให้เห็นว่าระบบการระบุวิดีโอของผู้ปฏิบัติงานที่เป็นมนุษย์สามารถเอาชนะได้อย่างง่ายดายด้วยวิธีการพื้นฐานในชีวิตประจําวันและทักษะเพียงเล็กน้อย – บางครั้งไม่จําเป็นต้องใช้แม้แต่ Deepfake เพื่อหลอกมนุษย์

ดูว่าคุณสามารถมองเห็น Deepfake ในแบบทดสอบเชิงโต้ตอบของเราได้หรือไม่!

Deepfakes คุกคามการยืนยันตัวตนออนไลน์ทั้งหมดอย่างไร

ในการยืนยันตัวตนจากระยะไกลอย่างน่าเชื่อถือคุณจะต้องดูบุคคลและเอกสารระบุตัวตนของพวกเขา การยืนยันแฮงเอาท์วิดีโอ – บางครั้งเรียกว่าการระบุวิดีโอ – หมายถึงกระบวนการพูดคุยกับบุคคลที่ถ่ายทอดสดผ่านซอฟต์แวร์แฮงเอาท์วิดีโอเพื่อพิสูจน์ว่าคุณเป็นใคร แต่เป็นตัวเลือกที่ไม่พึงปรารถนา – ไม่น้อยเพราะไม่สะดวก ต้องใช้แรงงานและต้นทุนมาก และไม่สามารถทํางานอัตโนมัติได้ (ปรับขนาดได้ยากกว่า)

Deepfakes สามารถฉีดในสตรีมวิดีโอสดได้ดังนั้นจึงเป็นภัยคุกคามที่สําคัญยิ่งกว่าต่อการตรวจสอบวิดีโอ มนุษย์มีความน่าเชื่อถือในการตรวจจับ Deepfake น้อยกว่าไบโอเมตริกซ์ นี่คือเหตุผลที่เราเตือนองค์กรให้จําไว้ว่า Deepfake และ Generative AI รูปแบบอื่นๆ ไม่ใช่ "ปัญหาไบโอเมตริกซ์" เป็นปัญหาการยืนยันตัวตนจากระยะไกล

การยืนยันตัวตนจากระยะไกลเป็นสิ่งสําคัญสําหรับองค์กรส่วนใหญ่ที่ดําเนินธุรกิจออนไลน์ ไม่สามารถต่อรองได้ในหลายกรณี ต่อต้านภัยคุกคามของ Deepfake องค์กรต้องใช้ AI เพื่อความปลอดภัยทางไซเบอร์ (เช่น ไบโอเมตริกซ์ที่ขับเคลื่อนด้วย AI)

ฉันไม่สามารถยืนยันผู้ใช้ด้วยวิธีไบโอเมตริกซ์อื่นเพื่อหลีกเลี่ยงการปลอมแปลงโดยสิ้นเชิงได้หรือไม่

คุณอาจสงสัยต่อไป: "เหตุใดวิธีการไบโอเมตริกซ์อื่นๆ จึงเป็นทางเลือกที่เหมาะสมสําหรับการยืนยันตัวตน คุณไม่สามารถใช้ม่านตาหรือการตรวจสอบสิทธิ์ด้วยเสียง คุณจึงไม่จําเป็นต้องจัดการกับ Deepfake เลย"

การตรวจสอบใบหน้าด้วยไบโอเมตริกซ์ได้กลายเป็นวิธีเดียวที่เชื่อถือได้ในการยืนยันตัวตนจากระยะไกลเนื่องจาก:

- วิธีการไบโอเมตริกซ์อื่น ๆ ไม่สามารถยืนยันตัวตนได้ พวกเขาสามารถรับรองความถูกต้องได้เท่านั้น นี่เป็นเพราะเสียงม่านตาและอื่น ๆ ของคุณโดยทั่วไปไม่ได้อยู่ในเอกสารระบุตัวตนใด ๆ ของคุณ (ไม่เหมือนใบหน้าของคุณ) ดังนั้นคุณจึงไม่มีอะไรที่เชื่อถือได้ในการตรวจสอบข้อมูลไบโอเมตริกซ์ – ไม่มีแหล่งที่มาของความจริง เป็นไปได้ในบางกรณี เช่น องค์กรอาจเข้าถึงข้อมูลลายนิ้วมืออย่างเป็นทางการ เป็นต้น แต่ไม่สามารถปรับขนาดได้เหมือนการยืนยันใบหน้า เช่นเดียวกับวิธีการแบบเดิม เช่น รหัสผ่านและ OTP ซึ่งล้มเหลวในการรักษาความปลอดภัยของผู้ใช้ทางออนไลน์โดยสิ้นเชิง คุณไม่สามารถแน่ใจในตัวตนของใครบางคนได้ 100% เพียงเพราะพวกเขารู้บางอย่าง (รหัสผ่าน) หรือเป็นเจ้าของบางสิ่ง (โทรศัพท์ที่มีรหัสอยู่)

- การโคลนนิ่งที่ขับเคลื่อนด้วย AI เป็นภัยคุกคามต่อวิธีการไบโอเมตริกซ์ทั้งหมด ตัวอย่างเช่น เสียงถือเป็นไบโอเมตริกซ์ที่ง่ายที่สุดในการโคลน คุณสามารถอ่านเพิ่มเติมเกี่ยวกับภัยคุกคามของการ โคลนเสียงได้ในบทความนี้ และ ข้อเสียของไบโอเมตริกซ์เสียงที่นี่

การป้องกันการโจมตี Deepfake

เมื่อเราพูดถึงภัยคุกคามของ Deepfake จะเป็นการเน้นย้ําว่าโซลูชันการตรวจสอบใบหน้าที่มีประสิทธิภาพมีความสําคัญเพียงใดในการป้องกันพวกเขา และเพื่อให้ความรู้แก่องค์กรเกี่ยวกับความแตกต่างที่เป็นผลสืบเนื่องระหว่างโซลูชันที่มีอยู่

ตามที่ Gartner Market Guide ปี 2023 ระบุไว้ว่า "ผู้นําด้านความปลอดภัยและการจัดการความเสี่ยงต้องทําให้การตรวจจับ Deepfake เป็นข้อกําหนดหลัก และควรสงสัยผู้ขายรายใดก็ตามที่ไม่ได้พูดคุยเกี่ยวกับความสามารถในเชิงรุก"

เพื่อลดความเสี่ยงที่เกี่ยวข้องกับการโจมตี Deepfake บนระบบไบโอเมตริกซ์ สามารถใช้มาตรการต่างๆ ได้:

- ไบโอเมตริกซ์หลายรูปแบบ: การรวมวิธีการไบโอเมตริกซ์หลายวิธี เช่น การตรวจสอบใบหน้าและการสแกนลายนิ้วมือ สามารถเพิ่มความปลอดภัยโดยทําให้ผู้โจมตีปลอมแปลงหลายรูปแบบพร้อมกันได้ยากขึ้น

- การตรวจจับความมีชีวิตชีวา: การใช้การตรวจสอบการตรวจจับความมีชีวิตชีวาตามหลักวิทยาศาสตร์สามารถช่วยแยกความแตกต่างระหว่างข้อมูลไบโอเมตริกซ์จริงและการเป็นตัวแทนสังเคราะห์ เช่น การปลอมแปลงซึ่งขาดสัญญาณชีพของชีวิต เรียนรู้เพิ่มเติมเกี่ยวกับเทคโนโลยีความมีชีวิตชีวาที่นี่

- การตรวจสอบอย่างต่อเนื่อง: ระบบไบโอเมตริกซ์ควรรวมการตรวจสอบอย่างต่อเนื่องและการตรวจจับความผิดปกติเพื่อระบุรูปแบบหรือพฤติกรรมที่ผิดปกติซึ่งอาจบ่งบอกถึงการโจมตีแบบ Deepfake องค์กรต้องยอมรับเทคนิคขั้นสูงที่สามารถปรับให้เข้ากับภูมิทัศน์ของภัยคุกคามทางไซเบอร์ที่เร่งตัวขึ้นอย่างรวดเร็ว (ไม่ใช่เทคนิคที่ต้องอาศัยการป้องกันแบบคงที่ – โซลูชันนี้เป็นบริการที่พัฒนาขึ้นมากกว่าซอฟต์แวร์)

โซลูชันไบโอเมตริกทางเทคนิคเช่นการตรวจจับความมีชีวิตชีวาตามหลักวิทยาศาสตร์และข่าวกรองภัยคุกคามที่ใช้งานอยู่จะเป็นศูนย์กลางในการระบุสื่อสังเคราะห์ อย่างไรก็ตาม การวิจัยในมนุษย์และทักษะการคิดอย่างมีวิจารณญาณยังคงมีความสําคัญในการระบุภัยคุกคามที่อาจเกิดขึ้น โซลูชันที่ดีที่สุดอยู่ที่การรวมจุดแข็งของทั้งมนุษย์และระบบอัตโนมัติเพื่อสร้างโซลูชันที่เข้าใจผิดได้ เช่นเดียวกับที่ iProov ทํา โดยใช้การตรวจสอบไบโอเมตริกซ์ที่สําคัญต่อภารกิจของเรากับความสามารถ iSOC ของเรา

คําถามที่ว่า "เราจะแน่ใจในตัวตนของใครบางคนทางออนไลน์ได้อย่างไร" เป็นหัวข้อที่สําคัญและจริงจังอย่างยิ่ง และจะไม่หายไป

เรียนรู้เพิ่มเติมเกี่ยวกับวิธีที่ iProov ป้องกัน Deepfakes โดยเฉพาะในโพสต์บล็อกนี้ และอ่านรายงานของเรา Deepfakes: พรมแดนใหม่ของอาชญากรรมออนไลน์