11. Januar 2024

Die Identitätsüberprüfung aus der Ferne ist eine der dringendsten Herausforderungen unseres zunehmend digitalen Zeitalters. Die Identität einer Person zu bestätigen, ohne sie persönlich zu sehen, ist eine Notwendigkeit, die sowohl an Bedeutung als auch an Schwierigkeit zunimmt.

Eine der heimtückischsten Bedrohungen für die Remote-Identitätsüberprüfung ist die Verwendung von durch generative KI erstellten Deepfakes. Deepfakes sind an sich nicht schädlich, können aber ein erhebliches Sicherheitsrisiko darstellen. Da es inzwischen unmöglich ist, synthetische Bilder mit dem menschlichen Auge zuverlässig von echten Bildern zu unterscheiden, hat sich die KI-gestützte Biometrie als die robusteste Verteidigung gegen Deepfakes erwiesen - und damit als die einzige zuverlässige Methode der Identitätsfernüberprüfung. Die Bekämpfung dieser Fälschungen erfordert kontinuierliche Forschung und unternehmenskritische Lösungen mit sich weiterentwickelnder Sicherheit. Auch die Menschen schätzen die Bequemlichkeit der biometrischen Gesichtsverifizierung - 72 % der Verbraucher weltweit bevorzugen die Gesichtsverifizierung für die Online-Sicherheit.

Da die biometrische Technologie jedoch immer weiter fortschreitet, suchen böswillige Akteure nach neuen und ausgefeilteren Methoden, um diese Systeme zu kompromittieren. Es ist jedoch wichtig, sich daran zu erinnern, dass Deepfakes keine Bedrohung für die biometrische Sicherheit sind - sie sind eine Bedrohung für jede Methode zur Überprüfung der Identität eines Menschen aus der Ferne.

Die Deepfake-Bedrohung: Ein Blick auf den Aufstieg der Deepfake-Technologie

Am Anfang waren Deepfakes nur ein harmloser Spaß, bei dem Menschen Videos und Bilder zu Unterhaltungszwecken erstellten. Wenn sie jedoch mit böswilligen Absichten und Cyberangriffswerkzeugen kombiniert werden, verwandeln sie sich schnell in unheilvolle Bedrohungen. Deepfakes haben sich schnell zu einer sehr wirksamen Methode entwickelt, um Angriffe auf die Cybersicherheit zu starten, gefälschte Nachrichten zu verbreiten und die öffentliche Meinung zu beeinflussen. Wahrscheinlich sind Sie schon einmal auf ein Deepfake gestoßen, ohne es zu bemerken.

Bei der Deepfake-Technologie werden Werkzeuge wie computergenerierte Bilder (CGI) und künstliche Intelligenz eingesetzt, um das Aussehen und Verhalten einer Person zu verändern. Algorithmen des maschinellen Lernens erzeugen hochrealistische synthetische Inhalte, um menschliches Verhalten, einschließlich Mimik und Sprache, zu imitieren. Wird diese Technologie in böser Absicht eingesetzt, kann sie dazu verwendet werden, gefälschte Identitäten zu erstellen, Menschen zu imitieren und sich beispielsweise Zugang zu sicheren Orten zu verschaffen.

Aufgrund der Raffinesse der Technologie erscheinen Deepfake-Inhalte geschulten Menschen und sogar einigen Lösungen zur Identitätsüberprüfung oft sehr realistisch, so dass sie nur schwer von echten und synthetischen Inhalten zu unterscheiden sind. Die rasante Entwicklung der KI bedeutet, dass sich auch Deepfakes ständig weiterentwickeln - sie sind keine statische Bedrohung.

Deepfake-Erkennung: Es ist erwiesen, dass Menschen Deepfakes nicht zuverlässig erkennen können

Wir haben eine Liste von Studien zusammengestellt, die zeigen, dass Menschen einfach kein verlässlicher Indikator für die Erkennung von Fälschungen sind:

- Eine Studie aus dem Jahr 2021 mit dem Titel "Deepfake detection by human crowds, machines, and machine-informed crowds" (Erkennung von Fälschungen durch Menschenmassen, Maschinen und maschinengestützte Menschenmassen) ergab, dass Menschen allein viel schlechter sind als Erkennungsalgorithmen. Die Erkennungsalgorithmen übertrafen sogar forensische Prüfer, die in dieser Aufgabe weitaus erfahrener sind als der Durchschnittsmensch. Die Studie fand auch keinen Hinweis darauf, dass Ausbildung/Training die Leistung verbessert.

- Eine weitere Studie aus dem Jahr 2021 mit dem Titel "Fooled twice: People cannot detect deepfakes but think they can" (Zweimal getäuscht: Menschen können Deepfakes nicht erkennen, glauben aber, dass sie es können) fand heraus, dass Menschen weniger in der Lage sind, Deepfakes zu erkennen, als sie denken; dass Menschen nicht zuverlässig in der Lage sind, manipulierte Videoinhalte zu erkennen; dass Training und Anreize die Fähigkeit nicht erhöhen; dass Menschen eine Tendenz zu einer falschen Ablehnungsrate haben; und schließlich, dass Menschen besonders anfällig dafür sind, von Deepfake-Inhalten beeinflusst zu werden.

- Im Jahr 2022 fand eine Gruppe von Sicherheitsforschern heraus, dass die Verifizierung von Videoanrufen von Mensch zu Mensch mit Betriebssystemsoftware und Aquarellfarben (d. h. digitaler Kunstmanipulation) leicht zu überwinden war. Dies zeigt, dass Video-Identifizierungssysteme, die von Menschen bedient werden, mit einfachen, alltäglichen Methoden und sehr wenig Geschick leicht zu überwinden sind - manchmal sind nicht einmal Deepfakes erforderlich, um Menschen zu täuschen.

Finden Sie heraus, ob Sie einen Deepfake in unserem interaktiven Quiz erkennen können!

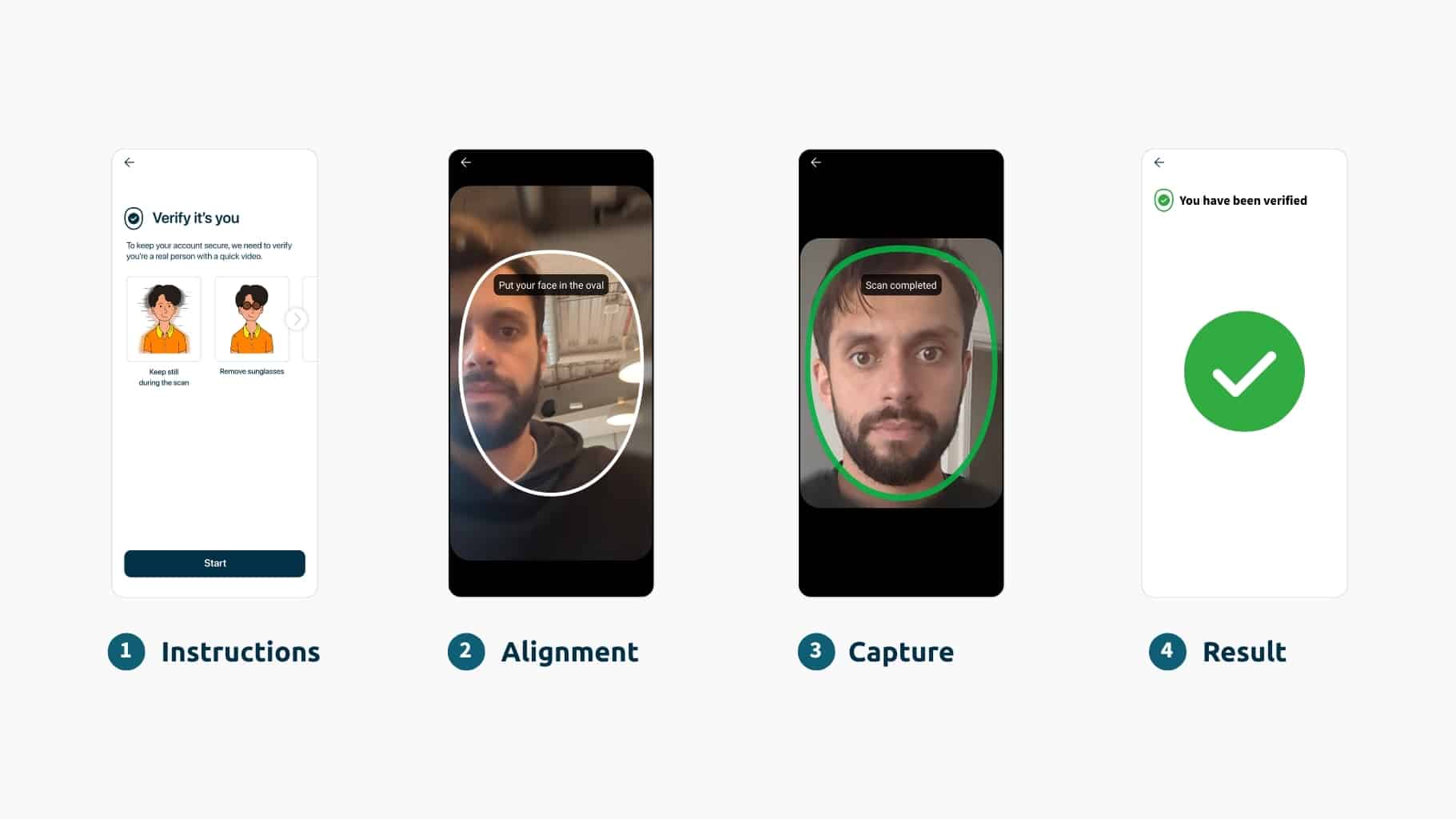

Wie Deepfakes die gesamte Online-Identitätsüberprüfung bedrohen

Um die Identität aus der Ferne zuverlässig zu überprüfen, müssen Sie die Person und ihr Ausweisdokument sehen. Die Verifizierung per Videoanruf - manchmal auch als Videoidentifizierung bezeichnet - bezieht sich auf das Verfahren, mit einer lebenden Person über eine Videoanrufsoftware zu sprechen, um zu beweisen, wer Sie sind. Dies ist jedoch eine unerwünschte Option - nicht zuletzt, weil sie unbequem, arbeits- und kostenintensiv ist und nicht automatisiert werden kann (und daher schwieriger zu skalieren ist).

Deepfakes können ohnehin in einen Live-Videostream eingespeist werden, weshalb sie eine noch größere Bedrohung für die Videoüberprüfung darstellen. Wie wir festgestellt haben, sind Menschen bei der Erkennung von Deepfakes weniger zuverlässig als Biometriker. Aus diesem Grund möchten wir Unternehmen darauf hinweisen, dass Deepfakes und andere Formen der generativen KI kein "biometrisches Problem" sind, sondern ein Problem der Identitätsüberprüfung aus der Ferne.

Die Identitätsüberprüfung per Fernzugriff ist für die meisten Unternehmen, die online Geschäfte tätigen, von entscheidender Bedeutung. In vielen Fällen ist sie nicht verhandelbar. Angesichts der Bedrohung durch Deepfakes müssen Unternehmen KI zum Wohle der Cybersicherheit einsetzen (d. h. KI-gestützte Biometrie).

Kann ich Benutzer nicht mit einer anderen biometrischen Methode verifizieren, um Deepfakes gänzlich zu vermeiden?

Sie könnten sich nun fragen: "Warum sind andere biometrische Methoden keine geeignete Alternative für die Identitätsüberprüfung? Kann man nicht einfach die Iris- oder Stimmauthentifizierung verwenden, so dass man sich überhaupt nicht mit Deepfakes befassen muss?"

Insbesondere die biometrische Gesichtsverifikation hat sich als einzige zuverlässige Methode der Identitätsüberprüfung aus der Ferne erwiesen, weil:

- Andere biometrische Verfahren können die Identität nicht überprüfen. Sie können sie nur authentifizieren. Das liegt daran, dass Ihre Stimme, Ihre Iris usw. in der Regel in keinem Ihrer Ausweisdokumente enthalten sind (im Gegensatz zu Ihrem Gesicht). Sie haben also nichts, dem Sie vertrauen können, um die biometrischen Daten zu überprüfen - keine Quelle der Wahrheit. In seltenen Fällen ist dies möglich - vielleicht hat eine Organisation beispielsweise Zugang zu offiziellen Fingerabdruckdaten. Aber es ist nicht so skalierbar wie die Gesichtsüberprüfung. Das Gleiche gilt für herkömmliche Methoden wie Passwörter und OTPs, die bei der Sicherheit der Nutzer im Internet völlig versagt haben. Man kann sich der Identität einer Person nicht zu 100 % sicher sein, nur weil sie etwas weiß (ein Passwort) oder etwas besitzt (ein Telefon mit einem Code).

- Das KI-gesteuerte Klonen ist eine Bedrohung für alle biometrischen Verfahren. Die Stimme zum Beispiel gilt als das am leichtesten zu klonende biometrische Merkmal. Mehr über die Bedrohung durch das Klonen der Stimme erfahren Sie in diesem Artikel und über die Nachteile der Stimmbiometrie hier.

Schutz vor Deepfake-Angriffen

Wenn wir über die Bedrohung durch Deepfakes sprechen, wollen wir betonen, wie wichtig eine robuste Lösung zur Gesichtsverifizierung ist, um sich dagegen zu schützen, und die Unternehmen über die wesentlichen Unterschiede zwischen den verfügbaren Lösungen aufklären.

Im Gartner Market Guide 2023 heißt es: "Sicherheits- und Risikomanagementverantwortliche müssen die Deepfake-Erkennung zu einer zentralen Anforderung machen und sollten jedem Anbieter gegenüber misstrauisch sein, der seine Fähigkeiten nicht proaktiv erörtert".

Um die mit Deepfake-Angriffen auf biometrische Systeme verbundenen Risiken zu mindern, können verschiedene Maßnahmen ergriffen werden:

- Multimodale biometrische Verfahren: Die Kombination mehrerer biometrischer Methoden, wie Gesichtsverifikation und Fingerabdruck-Scanning, kann die Sicherheit erhöhen, da es für Angreifer schwieriger ist, mehrere Modalitäten gleichzeitig zu fälschen.

- Erkennung von Lebenszeichen: Die Implementierung von wissenschaftlich fundierten Prüfungen zur Erkennung von Lebendigkeit kann dazu beitragen, echte biometrische Daten von synthetischen Darstellungen zu unterscheiden, z. B. von Deepfakes, die keine Lebenszeichen aufweisen. Erfahren Sie hier mehr über die Liveness-Technologie.

- Kontinuierliche Überwachung: Biometrische Systeme sollten eine kontinuierliche Überwachung und Anomalieerkennung beinhalten, um ungewöhnliche Muster oder Verhaltensweisen zu erkennen, die auf einen Deepfake-Angriff hindeuten könnten. Unternehmen müssen fortschrittliche Techniken einsetzen, die sich an die schnell wachsende Landschaft von Cyber-Bedrohungen anpassen können (und nicht solche, die sich auf statische Schutzmaßnahmen verlassen - die Lösung ist ein sich entwickelnder Dienst und keine Software).

Technische biometrische Lösungen wie die wissenschaftlich fundierte Erkennung von Lebendigkeit und aktive Bedrohungserkennung werden bei der Identifizierung synthetischer Medien eine zentrale Rolle spielen. Menschliche Forschung und kritisches Denken sind jedoch nach wie vor unerlässlich, wenn es darum geht, potenzielle Bedrohungen zu identifizieren. Die ultimative Lösung liegt in der Kombination der Stärken von Mensch und Automatisierung, um eine narrensichere Lösung zu schaffen - so wie iProov es tut, indem wir unsere missionskritische biometrische Verifizierung mit unseren iSOC-Fähigkeiten kombinieren.

Die Frage "Wie können wir uns der Identität einer Person im Internet sicher sein?" ist ein äußerst wichtiges und ernstes Thema, das nicht verschwinden wird.

Erfahren Sie mehr darüber, wie iProov speziell gegen Deepfakes vorgeht, in diesem Blogbeitrag und lesen Sie unseren Bericht Deepfakes: Die neue Grenze der Online-Kriminalität.