26 novembre 2024

L'intelligenza artificiale (IA) è al tempo stesso il nostro più grande alleato e il nostro più pericoloso avversario. La posta in gioco non è mai stata così alta, poiché le organizzazioni di tutto il mondo sono alle prese con minacce guidate dall'IA, come i deepfakes e i contenuti generativi creati dall'IA, e allo stesso tempo si affidano all'IA per rilevare e mitigare questi potenziali pericoli.

In questa serie di due puntate, ci occuperemo di questi argomenti esaminando il panorama delle minacce, discutendo l'impatto dell'IA attraverso la lente dei decisori tecnologici e prendendo in considerazione le raccomandazioni di Gartner per trovare le migliori soluzioni e raccomandazioni.

I risultati del sondaggio evidenziano come l'IA sia "un'arma a doppio taglio".

L'ultimo sondaggio globale di iProov - The Good, The Bad, and The Ugly - ha raccolto le opinioni di 500 decisori tecnologici di Regno Unito, Stati Uniti, Brasile, Australia, Nuova Zelanda e Singapore sulla minaccia dell'IA generativa e dei deepfakes.

Questa indagine ha rivelato un paradosso sorprendente: mentre 68% degli intervistati ritiene che l'IA generativa crei minacce alla cybersicurezza, un ancora più ampio 84% ritiene che abbia un impatto sulla protezione da queste stesse minacce.

![The Artificial Intelligence Paradox in Cybersecurity [Part 1] 4 Il buono, il brutto, il cattivo, l'impatto dell'apprendimento automatico dell'intelligenza artificiale](https://www.iproov.com/wp-content/uploads/2024/11/Good-Bad-Ugly-Extract-Impact-Of-Gen-AI-Machine-Learning.png)

Da un lato, le tecnologie basate sull'intelligenza artificiale, come i deepfakes, hanno fornito agli aggressori strumenti sofisticati per impersonare le persone e creare false identità online. impersonare individui e creare false identità convincenti online.

D'altra parte, l'IA funge da linea di difesa fondamentale. Ad esempio, il rilevamento biometrico della presenza di persone utilizza algoritmi di intelligenza artificiale per identificare e vanificare i tentativi di inganno digitale, rilevando immagini e video manipolati (con un'affidabilità migliore dell'occhio umano). migliore affidabilità rispetto all'occhio umano).

L'Arena degli algoritmi: IA contro IA

Mentre gli attacchi basati sull'intelligenza artificiale diventano sempre più sofisticati, crescono anche le difese basate sull'intelligenza artificiale. Questa corsa agli armamenti tecnologici sta ridisegnando la sicurezza informatica.

I criminali informatici sfruttano l'intelligenza artificiale per creare e-mail di phishing più convincenti, sviluppare malware complessi e orchestrare attacchi su larga scala. Allo stesso tempo, i team di cybersecurity sfruttano la potenza dell'IA per rilevare le anomalie, prevedere le potenziali minacce e rispondere agli incidenti con una velocità e una precisione senza precedenti.

Non sorprende che i deepfakes siano ora al terzo posto tra le preoccupazioni più diffuse tra gli intervistati, nel seguente ordine:

- Violazione delle password (64%)

- Ransomware (63%)

- Attacchi di phishing/social engineering (61%)

- Deepfakes (61%)

L'inclusione dei deepfakes tra queste tre principali preoccupazioni segnala una crescente consapevolezza di questa minaccia emergente.

![The Artificial Intelligence Paradox in Cybersecurity [Part 1] 5 Statistiche sulle opinioni di Deepfake in America Latina](https://www.iproov.com/wp-content/uploads/2024/11/Latam-Deepfake-opinions-statistics.png)

Le organizzazioni devono adottare tecniche avanzate che si adattino alla rapida accelerazione delle minacce informatiche, utilizzando l'IA per il bene della sicurezza informatica.

La crisi di Deepfake nella sicurezza aziendale

Non c'è da stupirsi che l'ascesa dei deepfakes sia emersa come uno degli sviluppi più allarmanti legati all'intelligenza artificiale.

I deepfake sono una forma di media sintetici altamente realistici che possono impersonare gli individui con una precisione sorprendente, ponendo rischi significativi per i sistemi di verifica e autenticazione delle identità.

Il nostro sondaggio ha rilevato che il 47% delle organizzazioni si è già imbattuto in un attacco deepfake, un numero destinato ad aumentare con la crescita della sofisticazione e dell'accessibilità degli strumenti. Questo aumento può essere dovuto al miglioramento delle tecnologie di rilevamento che scoprono attacchi precedentemente inosservati o alle tecniche avversarie che avanzano rapidamente, rendendo i deepfake più diffusi. Le organizzazioni potrebbero non essersi nemmeno rese conto di avere un problema di deepfake fino ad ora.

L'impatto potenziale dei deepfakes sulle organizzazioni è notevole:

- Il 70% ritiene che gli attacchi deepfake avranno un impatto elevato sulla propria organizzazione

- Il 64% teme la perdita di dati sensibili

- Il 61% è preoccupato per i danni alla reputazione

- Il 60% teme sanzioni o perdite finanziarie

Nonostante il pericolo chiaro e presente, il 62% dei responsabili della cybersecurity teme che la propria organizzazione non prenda abbastanza sul serio le minacce deepfake. Questo scollamento tra la realtà e la preparazione dell'organizzazione è una preoccupazione significativa.

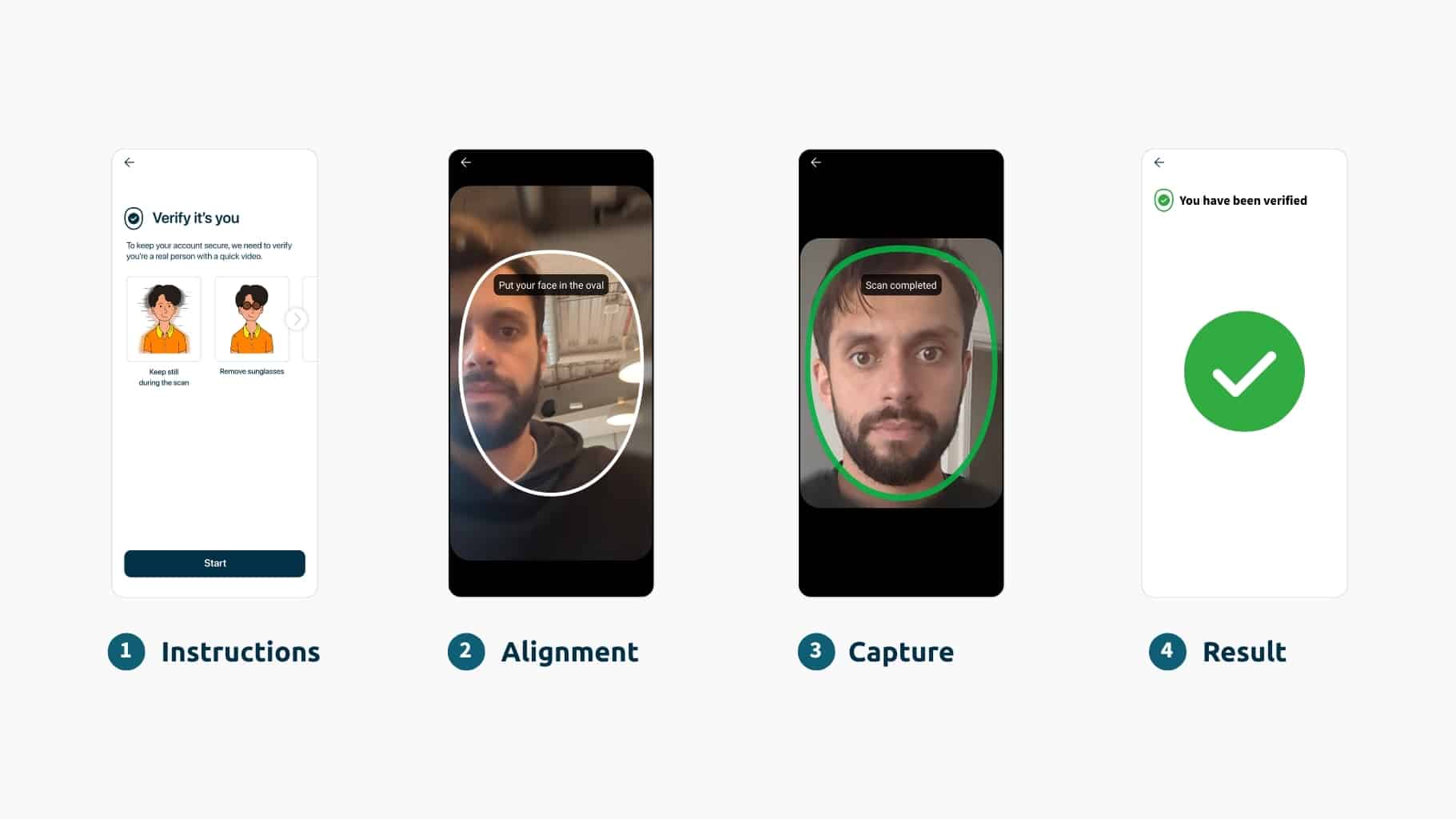

Soluzioni biometriche facciali: La difesa in prima linea

In risposta, le organizzazioni si stanno rivolgendo a misure di sicurezza avanzate. Un clamoroso 75% dei leader tecnologici intervistati ha dichiarato di rivolgersi a soluzioni biometriche facciali come difesa primaria contro i deepfake.

La preferenza per la biometria facciale non è solo una tendenza, ma il riconoscimento che le misure di sicurezza tradizionali non sono più sufficienti a contrastare gli attacchi sofisticati basati sull'intelligenza artificiale, in quanto non sono indicatori verificabili o affidabili dell'identità. I malintenzionati possono facilmente rubare una password o intercettare un OTPanche la la vostra voce è ora soggetta a spoofing e a variazioni nel tempo (in più, è difficile ottenere una "fonte" autentica autentica con cui confrontare la voce).

La biometria facciale associa il volto di un individuo a un documento d'identità affidabile per il governo, fornendo un alto livello di garanzia che l'utente sia la persona giusta, in tempo reale. La biometria facciale è considerata il tipo di soluzione biometrica più efficace per la sua facilità d'uso, la sicurezza e l'inclusività.

La nostra indagine rivela che le organizzazioni stanno implementando diverse soluzioni per affrontare la minaccia dei deepfakes:

![The Artificial Intelligence Paradox in Cybersecurity [Part 1] 6 Strumenti di soluzione statistica utilizzati per affrontare la minaccia dei deepfakes](https://www.iproov.com/wp-content/uploads/2024/11/Statistics-solutions-tools-used-to-address-threat-of-deepfakes.png)

Queste statistiche dimostrano che le organizzazioni stanno adottando un approccio alla sicurezza consigliato su più livelli, con la biometria che svolge un ruolo centrale. Nel complesso, le soluzioni biometriche facciali con liveness offrono un livello di sicurezza difficile da intaccare, rendendole uno strumento cruciale nella lotta contro i deepfake e altre minacce generate dall'intelligenza artificiale.

Il panorama in evoluzione della sicurezza informatica

Le organizzazioni stanno adattando le loro strategie per affrontare queste nuove sfide:

- Il 68% ha rivisto i propri programmi di cybersecurity per includere le considerazioni sui rischi introdotti dall'IA generativa

- L'88% ha implementato politiche sull'utilizzo di nuovi strumenti di IA

- L'83% ha aumentato gli investimenti o il budget per i programmi di cybersecurity

Questi cambiamenti riflettono una crescente consapevolezza della necessità di misure di sicurezza adattive ed evolutive di fronte alle minacce guidate dall'intelligenza artificiale.

In realtà, può essere difficile tenere il passo con tutti gli ultimi sviluppi nel mondo delle minacce basate sull'intelligenza artificiale. Ecco perché è importante scegliere una soluzione di verifica dell'identità in grado di monitorare e gestire tali minacce per la vostra organizzazione in tempo reale.

iProov utilizza l'intelligenza artificiale a fin di bene: i modelli di apprendimento profondo, tra cui le reti neurali convoluzionali (CNN), possono aiutare a rilevare e abbinare le immagini. Allo stesso tempo, la computer vision garantisce che le immagini appartengano a una persona reale e non a un deepfake, a una maschera o ad altri supporti sintetici.

In modo critico, quasi tutti gli intervistati (94%) concordano sul fatto che un partner per la sicurezza biometrica debba essere più di un semplice prodotto software; devono fornire un servizio in evoluzione.

Guardate questo video per saperne di più su come iProov fornisce la sicurezza biometrica come servizio in evoluzione e adattabile, al contrario di una soluzione statica che non è in grado di rispondere alle vulnerabilità zero-day e di stare un passo avanti agli attacchi dell'intelligenza artificiale. attacchi della gen AI:

Punti di forza

- L'intelligenza artificiale presenta sia minacce significative che potenti difese nella sicurezza informatica

- I deepfake sono ora una delle principali preoccupazioni per le organizzazioni

- Le soluzioni biometriche, in particolare la biometria facciale con liveness, sono la difesa preferita contro gli attacchi basati sull'intelligenza artificiale.

- Le organizzazioni devono e stanno attivamente adattando le loro strategie per affrontare i rischi legati all'IA

Guardare avanti

Le organizzazioni devono rimanere informate sugli ultimi sviluppi dell'IA e della cybersecurity. Il panorama è in rapida evoluzione, con l'emergere costante di nuove minacce e difese.

Tuttavia, non tutte le soluzioni biometriche sono uguali. iProov è l'unico fornitore di verifica biometrica del volto che analizza le informazioni reali sulle minacce. Non ci limitiamo ad aiutare le organizzazioni a mettere a punto le loro difese: siamo noi la difesa, rimanendo attivamente un passo avanti rispetto all'evoluzione delle minacce. Sfruttando le informazioni in tempo reale sulle minacce e il monitoraggio proattivo tramite iSOC, garantiamo che i sistemi biometrici siano resilienti, adattivi e in grado di contrastare anche gli attacchi più sofisticati.

Nella seconda parte di questa serie, esploreremo come le organizzazioni possono sfruttare efficacemente l'IA a fin di bene - per migliorare la sicurezza - con un focus che si allinea alle raccomandazioni prescrittive di Gartner per combattere le minacce deepfake, semplificando il processo di approvvigionamento biometrico/liveness per voi.

Leggi la seconda parte: Come iProov soddisfa le raccomandazioni di Gartner per la difesa da Deepfake